Apple xác nhận với trang 9to5mac rằng họ đã quét file đính kèm trong iCloud Mail kể từ năm 2019 đến giờ để nhận diện nội dung CSAM. Theo Apple, các email không được mã hoá nên việc quét nội dung khá đơn giản. Đồng thời xác nhận họ chưa bao giờ quét iCloud Photos của người dùng cũng như các bản backup lưu trên iCloud.

Việc Apple sử dụng thuật toán và thông tin từ các tổ chức bảo vệ trẻ em cho CSAM đang làm dấy lên lo ngại về quyền riêng tư của người dùng. Có rất nhiều ý kiến trái chiều về vấn đề này. CEO Tim Cook mới đây đã phát biểu ‘Technology will only work if it has people’s trust‘ (tạm dịch: Công nghệ chỉ thực sự hữu ích nếu có được lòng tin của mọi người) như lời khẳng định công ty luôn đặt quyền lợi khách hàng lên hàng đầu.

Ngoài iCloud Mail, Apple cũng từng quét (một cách có hạn chế) thêm một số data khác ở quy mô nhỏ nhưng Apple không nói rõ data đó cụ thể là gì. Nhưng không phải các bản backup trên iCloud.

Những thông tin trái chiều

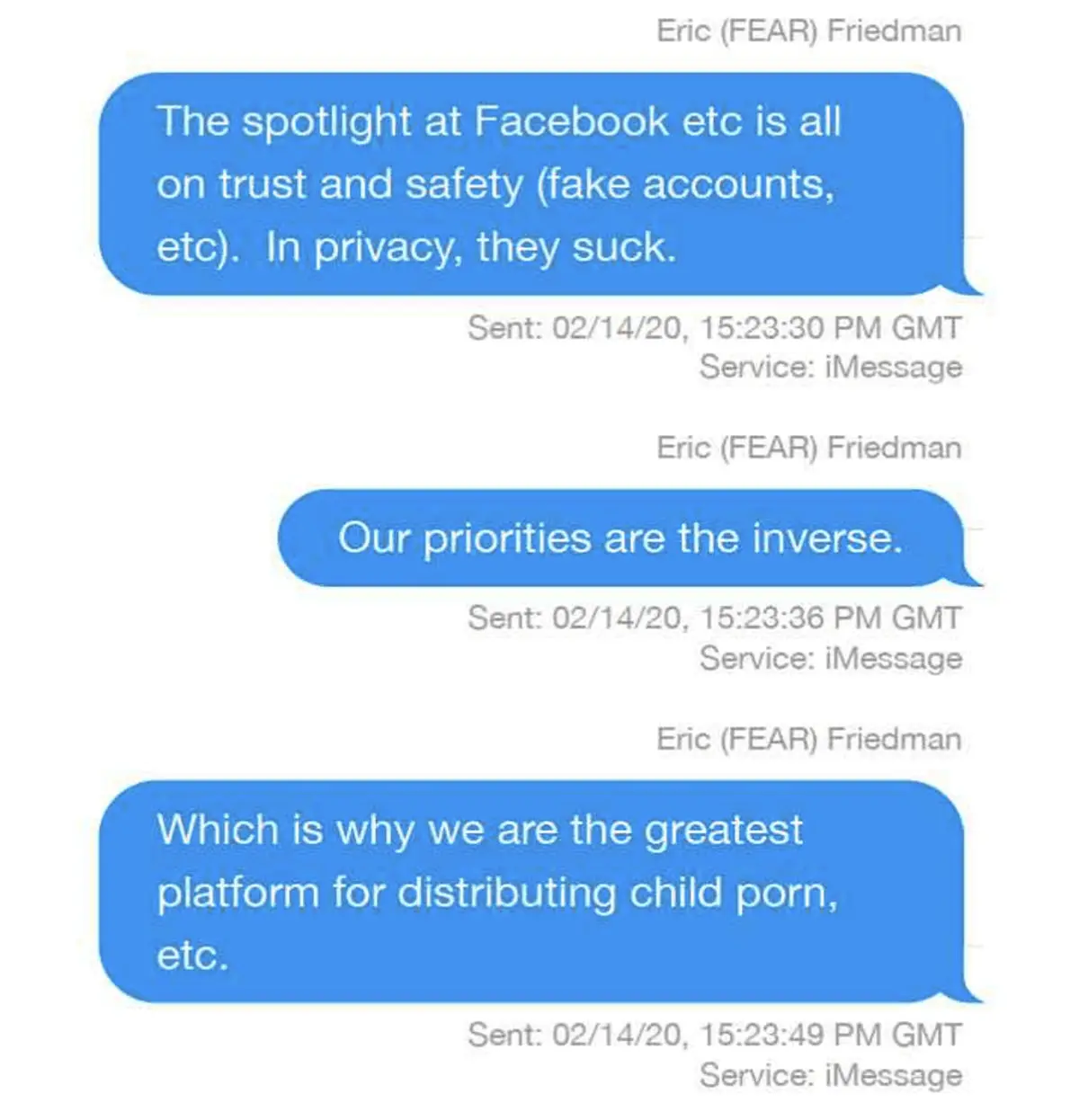

Eric Friedman, Trưởng ban Fraud Engineering Algorithms and Risk của Apple từng ghi câu: ‘Which is why we are the greatest platform for distributing child porn‘ trong một đoạn chat iMessage khi nói về tính bảo mật của Apple. Apple cung cấp hình này trong mớ tài liệu dùng trong vụ kiện với Epic Games.

Từ đó dấy lên câu hỏi: Nếu Apple không quét ảnh trên iCloud Photos thì làm sao họ biết được điều này?

Apple không bình luận về phát biểu của Eric Friedman. Nhưng họ nói công ty không bao giờ quét iCloud Photos.

Ngoài ra còn một số thông tin khác cũng ủng hộ giả thuyết này. Ví dụ như bản lưu của trang Our Commitment to Child Safety của Apple ghi (phần bôi đen là nhấn mạnh của 9to5mac):

‘Apple is dedicated to protecting children throughout our ecosystem wherever our products are used, and we continue to support innovation in this space. We have developed robust protections at all levels of our software platform and throughout our supply chain. As part of this commitment, Apple uses image matching technology to help find and report child exploitation. Much like spam filters in email, our systems use electronic signatures to find suspected child exploitation. We validate each match with individual review. Accounts with child exploitation content violate our terms and conditions of service, and any accounts we find with this material will be disabled.‘

Và Jane Horvath, Chief Privacy Officer của Apple, hồi tháng 1/2020 từng phát biểu tại một hội nghị chuyên về Tech là Apple dùng công nghệ sàng lọc (‘screening’) để tìm những hình ảnh trái pháp luật và sẽ vô hiệu hóa những tài khoản đó nếu Apple có đủ bằng chứng về nội dung xâm hại trẻ em. Tuy nhiên họ không nói cụ thể làm bằng cách nào.