Apple chuẩn bị tung ra 3 chức năng mới để bảo vệ trẻ em không bị lạm dụng online. Bao gồm: nhận hoặc gửi hình ảnh nhạy cảm qua Messages; tự nhận diện và báo công an nếu iCloud Photos của người dùng có chứa ảnh nhạy cảm của trẻ em CSAM; đồng thời nâng cấp Siri lẫn Search để chúng có thể cung cấp thông tin cần thiết khi người dùng search những nội dung này.

Những tính năng này đa phần sử dụng Machine Learning chạy trên máy của người dùng để đảm bảo tối đa quyền riêng tư. Chúng sẽ được cập nhật cho iOS 15, iPadOS 15 và macOS Monterey cho iPhone, iPad và máy Mac cuối năm nay.

Gửi nội dung nhạy cảm qua tin nhắn Messages

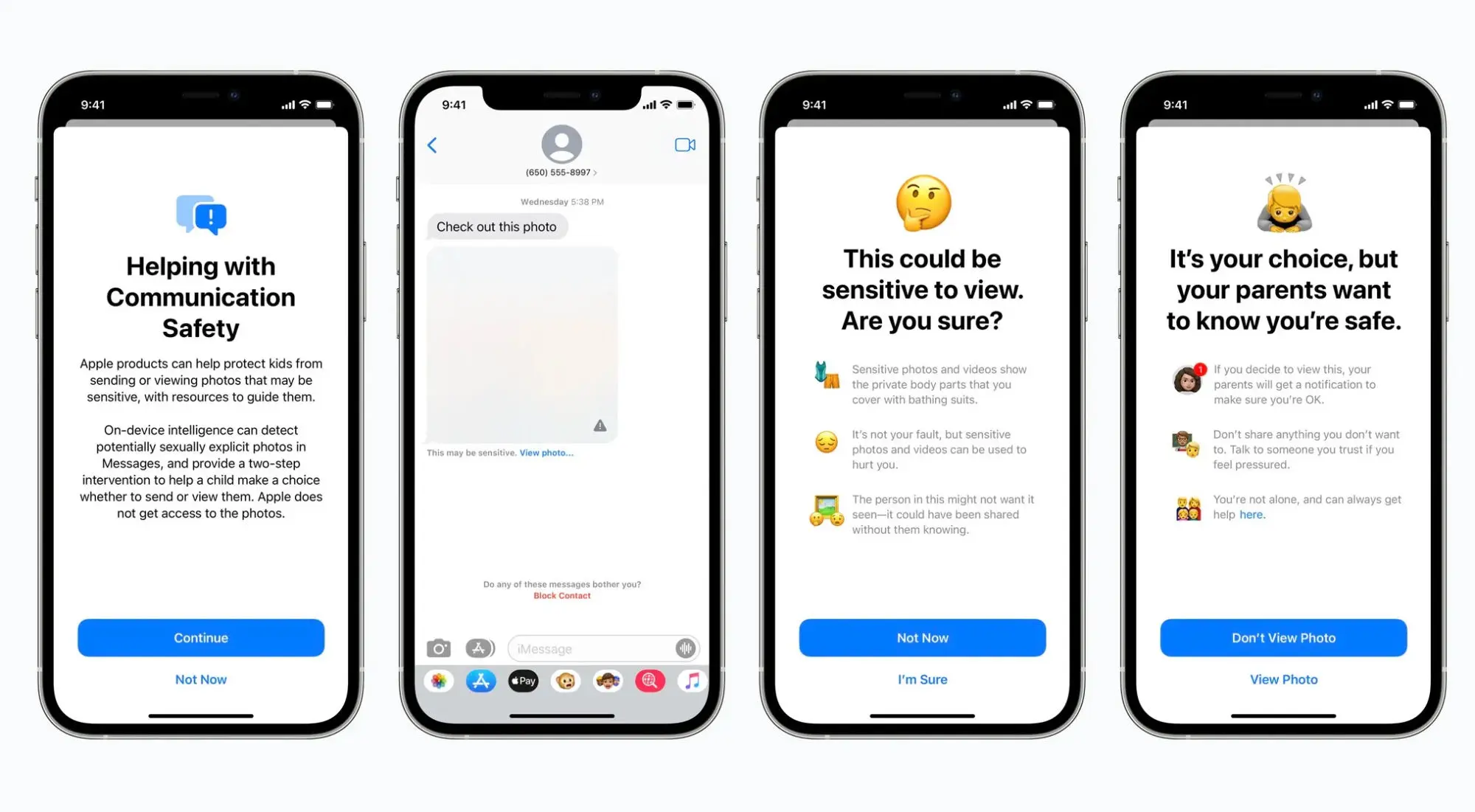

Bạn cần phải setup iCloud Family trước và add tài khoản của trẻ vào Family. Khi trẻ nhận hoặc gửi hình ảnh có nội dung nhạy cảm qua app Messages, trẻ sẽ nhận được cảnh báo trên màn hình. Cụ thể:

- Khi nhận ảnh nhạy cảm mà người khác gửi tới, máy sẽ làm mờ ảnh đó trước đồng thời hiện cảnh báo rằng đây có thể chứa nội dung nhạy cảm. Nếu trẻ tiếp tục bấm ‘View photo’ để xem hình thì một cảnh báo nữa sẽ tiếp tục hiện ra giải thích vì sao ảnh đó nhạy cảm. Và nếu bấm xem thì phụ huynh trong gói iCloud Family cũng sẽ nhận được thông báo để có hành động kịp thời.

- Ngược lại, khi trẻ cố gửi ảnh nhạy cảm thì bảng cảnh báo tương tự cũng sẽ hiện ra trước khi ảnh được gửi đi. Nếu tiếp tục gửi thì phụ huynh sẽ nhận và xem được ảnh đó. Áp dụng cho trẻ dưới 13 tuổi.

Để đảm bảo quyền riêng tư, Apple giải thích trong việc này họ không quét hay đọc lén nội dung của người dùng. Thay vào đó họ dùng Machine Learning chạy trực tiếp trên iPhone, iPad, Mac để phân tích nội dung ảnh và tự quyết định đó có phải là nội dung nhạy cảm hay không. Toàn bộ quá trình này được mã hóa và diễn ra trên máy người dùng. Apple không thể truy cập hay xem được.

Tính năng sẽ được tung ra vào cuối năm nay, trước tiên là tại Mỹ.

Tự động nhận diện ảnh nhạy cảm liên quan đến trẻ em, CSAM

Nếu iCloud Photos của bất kỳ ai có chứa ảnh nhạy cảm về trẻ em và bị hệ thống của Apple phát hiện được thì Apple sẽ báo cho trung tâm bảo vệ trẻ em National Center for Missing & Exploited Children tại Mỹ phối hợp với cơ quan chức năng để có biện pháp xử lý kịp thời.

CSAM là viết tắt của Child Sexual Abuse Material dùng để chỉ các nội dung nhạy cảm có liên quan đến trẻ em. Apple sẽ dùng Machine Learning để xác định ảnh lưu trong máy có phải là CSAM không. Cụ thể:

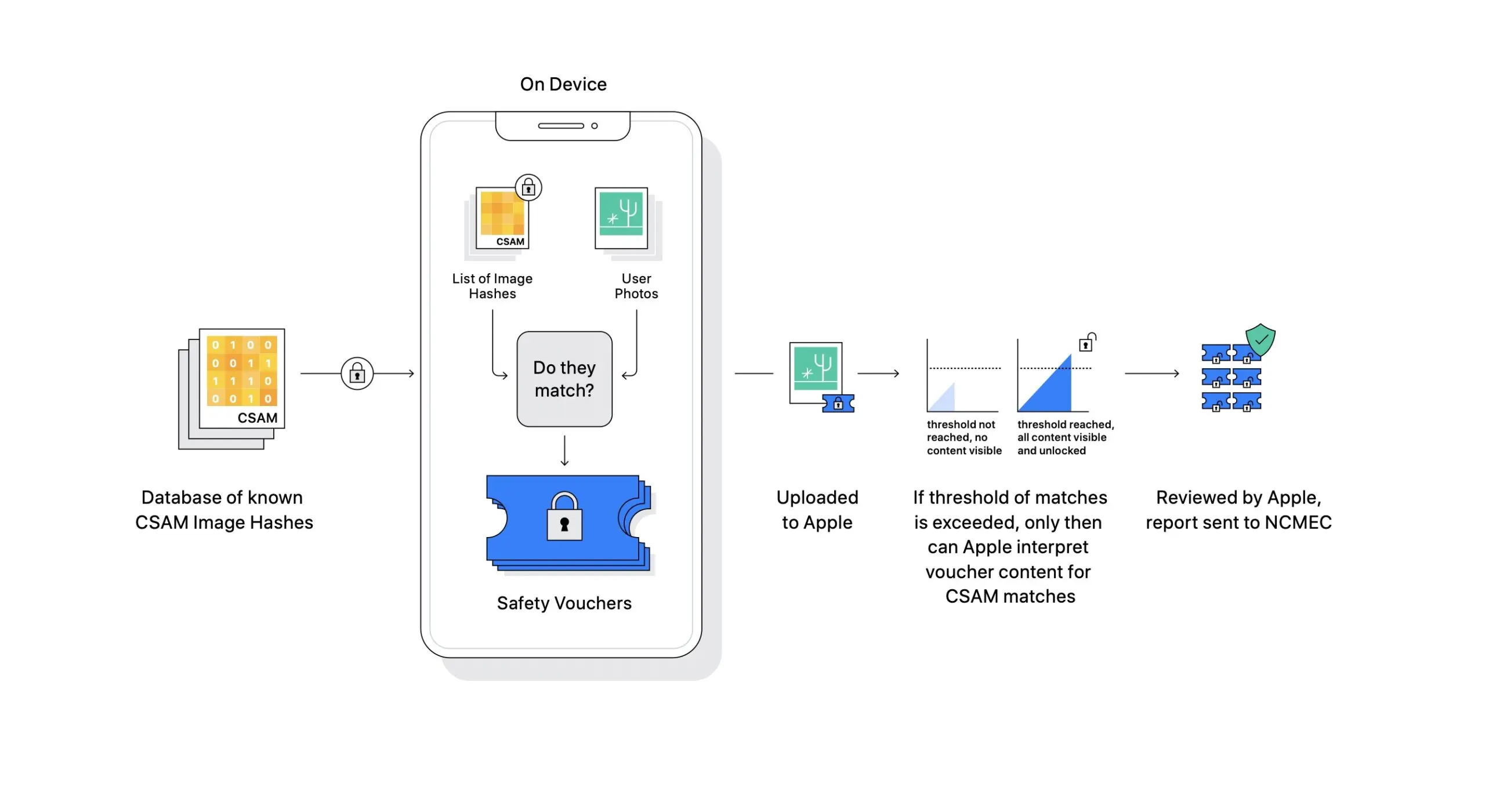

- Trước khi ảnh được up lên iCloud, máy sẽ dùng thuật toán để phân tích ảnh chứa trong máy của người dùng xem có trùng với dữ liệu CSAM mà cơ quan nói trên cung cấp hay không. Cả ảnh và dữ liệu CSAM dùng trong quy trình này đều được mã hóa dưới dạng hash để không ai có thể xem được, kể cả Apple. Dữ liệu CSAM thì được lưu sẵn trong một khu vực riêng trên máy người dùng và cũng không thể xem được.

- Nếu phát hiện có ảnh CSAM, hệ thống vẫn cho up ảnh lên iCloud đồng thời kích hoạt bộ đếm 1, 2, 3… Lúc này Apple sẽ chưa ngó đến nội dung đó.

- Khi bộ đếm đạt đến con số nhất định (Apple không công bố là bao nhiêu) (Update: 30 lần), Apple sẽ bắt đầu vào cuộc, không dùng Machine Learning nữa mà sẽ tự tay xem xét trường hợp đó, khóa tài khoản của người dùng và report lên cơ quan bảo vệ trẻ em.

Sở dĩ áp dụng bộ đếm là vì Apple muốn chắc chắn rằng hệ thống làm việc chính xác, không bị ‘false alarm’. Bước cuối của quy trình này vẫn có sự tham gia của con người để đảm bảo không có nhầm lẫn nào ở đây. Nếu có nhầm lẫn thì người dùng vẫn có thể phản hồi để khôi phục tài khoản của họ. Apple cho biết khả năng xảy ra lỗi là 1/1 ngàn tỷ account/năm.

Cần nói rõ thêm là Apple chỉ phân tích ảnh lưu trên iCloud Photos mà thôi. Những ảnh chỉ lưu offline trong máy sẽ không dính đến quy trình này. Những ảnh không bị đánh dấu CSAM lúc up lên iCloud cũng sẽ không bị Apple quét hay xử lý.

Tính năng CSAM sẽ sớm được phát hành đầu tiên ở Mỹ.

Tra cứu thông tin Child Safety với Siri & Search

Sau cùng, Apple còn bổ sung thêm dữ liệu cho Siri và tính năng Search để chúng có thể đưa ra những phản hồi hữu ích khi người dùng hỏi về CSAM. Ví dụ như khi muốn report CSAM thì cần làm như thế nào, liên hệ ai. Ngoài ra Siri & Search cũng có thể giải thích cho người dùng về những thắc mắc xung quanh CSAM.

Những nâng cấp này sẽ được bổ sung vào iOS 15, iPadOS 15, watchOS 8 và macOS Monterey phát hành vào cuối năm nay.