Sau khi thuật toán nhận diện ảnh NeuralHash được đăng công khai trên GitHub bởi một user, các developer đã nhanh chóng tìm ra cách để đánh lừa nó. Họ dùng hai hình hoàn toàn khác nhau nhưng có chung dòng mã hash. Qua đó đánh lừa hệ thống của Apple và dẫn đến khả năng ảnh có thể bị đánh dấu sai, hoặc có chứa nội dung CSAM. Nhưng đó chỉ là một phần nhỏ trong câu chuyện.

Tóm tắt tình hình

Bữa trước Apple công bố họ sẽ áp dụng cơ chế nhận diện ảnh nhạy cảm của trẻ em, gọi tắt là CSAM (Child Sexual Abuse Material). Trong cơ chế này, iPhone, iPad và máy Mac của người dùng sẽ tự động chạy NeuralHash, một thuật toán trong Machine Learning, để phân tích ảnh chứa trong máy của họ.

Nếu phát hiện có ảnh CSAM, ảnh được up lên iCloud Photos và xảy ra 30 lần như vậy thì Apple sẽ bắt đầu đánh giá trường hợp này và báo cơ quan chức năng nếu đó đúng là nội dung CSAM.

Cách đây hai hôm có người đã lừa được NeuralHash.

Apple nói gì?

Apple nói đó chưa phải là phiên bản sau cùng. Sau NeuralHash vẫn còn hai ‘cửa’ nữa. NeuralHash là thành phần cơ bản trong toàn hệ thống nhận diện CSAM của Apple. Nó có thể được chia sẻ công khai để mọi người cùng nghiên cứu. Nhưng sau khi NeuralHash chạy xong thì Apple còn chạy thêm một thuật toán matching thứ hai (cái này không không khai), lần này là trên server của Apple. Và cửa sau cùng là con người. Dùng người thật để đánh giá tình huống bị hệ thống đánh dấu là CSAM. Để xem ảnh đó có đúng thật là nội dung CSAM hay không sau khi đã trải qua hai đợt xác minh bằng máy.

Gần đây, ông Craig Federighi, Senior Vice President mảng Software Engineering của Apple cũng tiết lộ ngưỡng giới hạn mà họ đặt ra cho tình huống ảnh bị đánh dấu CSAM là 30 ảnh. Hồi đầu Apple không nói. Mỗi lần ảnh bị đánh dấu là CSAM và up lên iCloud sẽ tính là 1 lần. Nếu chạm ngưỡng 30 lần thì thuật toán thứ hai sẽ được kích hoạt để kiểm tra kết quả của thuật toán thứ nhất là NeuralHash.

Apple cho biết thuật toán thứ hai này chạy độc lập và được dùng để xác minh những trường hợp bị đánh dấu sai hoặc ảnh bị xáo trộn dẫn đến hệ thống nhận diện sai.

Thuật toán thứ hai của Apple

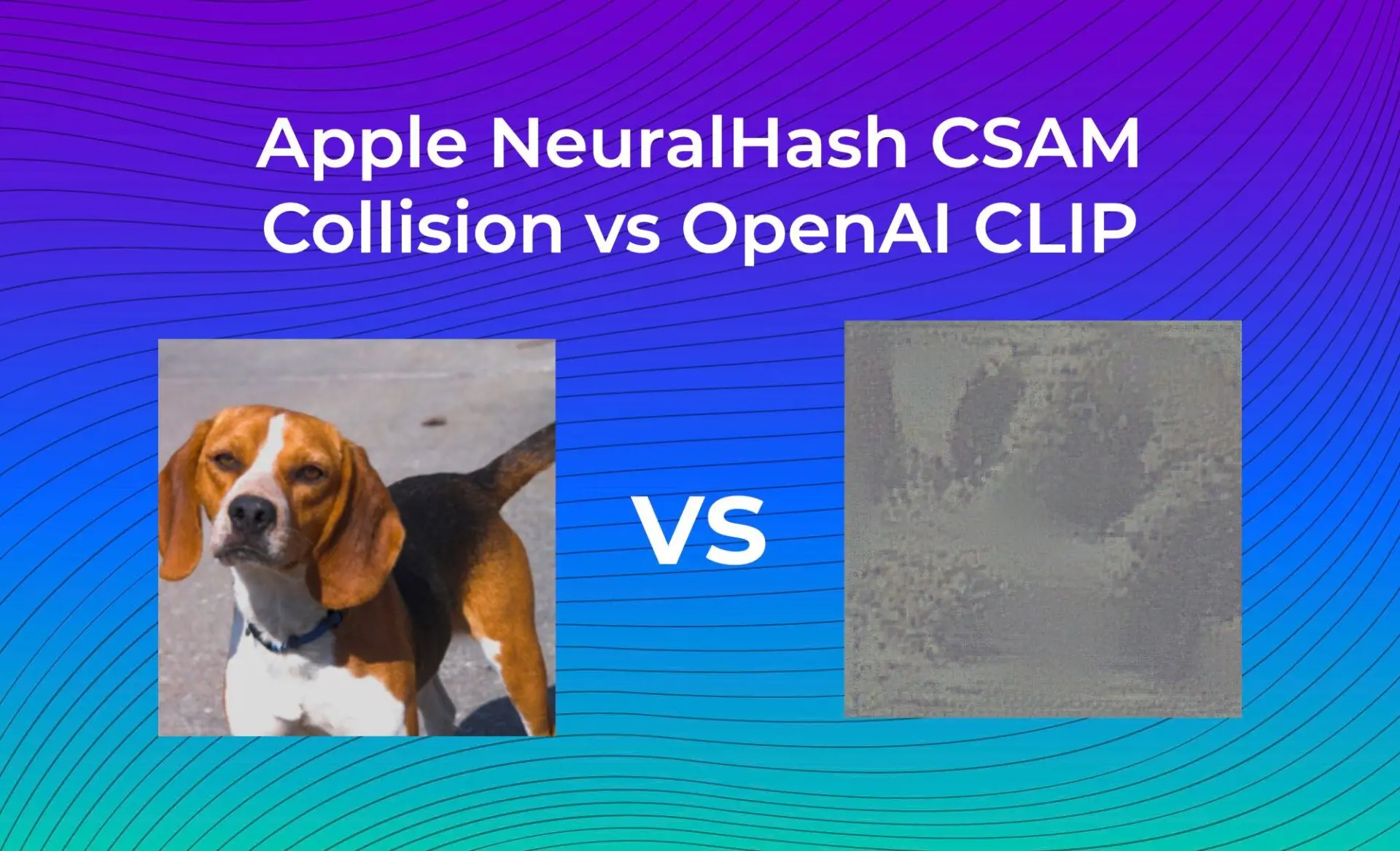

Brad Dwyer, CTO của trang Roboflow đã làm một thí nghiệm nhỏ. Anh sử dụng hai tấm hình khác nhau hoàn toàn mà người ta đã dùng để đánh lừa được NeuralHash và đưa vào chạy với một thuật toán khác là CLIP của OpenAI. CLIP cũng là thuật toán phân tích ảnh (và chữ) giống như NeuralHash nhưng có kỹ thuật trích xuất chi tiết ảnh khác với NeuralHash. Để xem thuật toán này có bị đánh lừa nữa không.

Kết quả: CLIP không bị lừa.

Brad nhận định rằng Apple có khả năng sẽ áp dụng thêm một thuật toán thứ hai để xác minh kết quả của thuật toán trước đó. Qua đó tăng thêm độ khó cho những ai muốn đánh lừa thuật toán này.

Chi tiết cú lừa

Người ta lừa thuật toán để đánh giá mức độ hiệu quả của nó và nghiên cứu về nó. Bạn có thể xem đoạn code NeuralHash người ta up trên GitHub tại đây. Đây là thuật toán NeuralHash tương tự như cái được nhúng trong hệ điều hành của Apple.

Vài giờ sau khi được up đã có người tìm ra cách lừa NeuralHash bằng việc dùng hai tấm hình hoàn toàn khác nhau nhưng lại có thể sinh ra chung một đoạn mã hash giống nhau. Đây được xem là bằng chứng để đánh giá độ hiệu quả của thuật toán, một ‘proof of concept’.

Ví dụ kịch bản thực tế: Một người nào đó gửi cho bạn rất nhiều hình. Những tấm hình trông không có vẻ gì là nội dung CSAM cả. Nhưng chúng lại có chung mã hash với những tấm hình CSAM, điều mà chắc bạn không bao giờ nhận ra. Như thường lệ, iPhone của bạn sẽ tự động up toàn bộ hình lên iCloud. Rồi bị thuật toán phát hiện, chạm ngưỡng 30 lần. Thế là tài khoản iCloud của bạn bị khóa và bạn vướng vào rắc rối.

Tuy nhiên công bằng mà nói thì người ác ý đó vẫn phải có được dữ liệu hash CSAM từ các tổ chức mà Apple đang sử dụng thì mới có thể ép cho hệ thống so sánh đúng và đánh dấu CSAM được.

Mặc dù tình huống này sẽ được bạn và phía Support của Apple tháo gỡ nhanh chóng thôi. Cũng chưa ai báo cảnh sát cả. Nhưng đó là rắc rối, là sự phiền hà.

Cùng chủ đề: