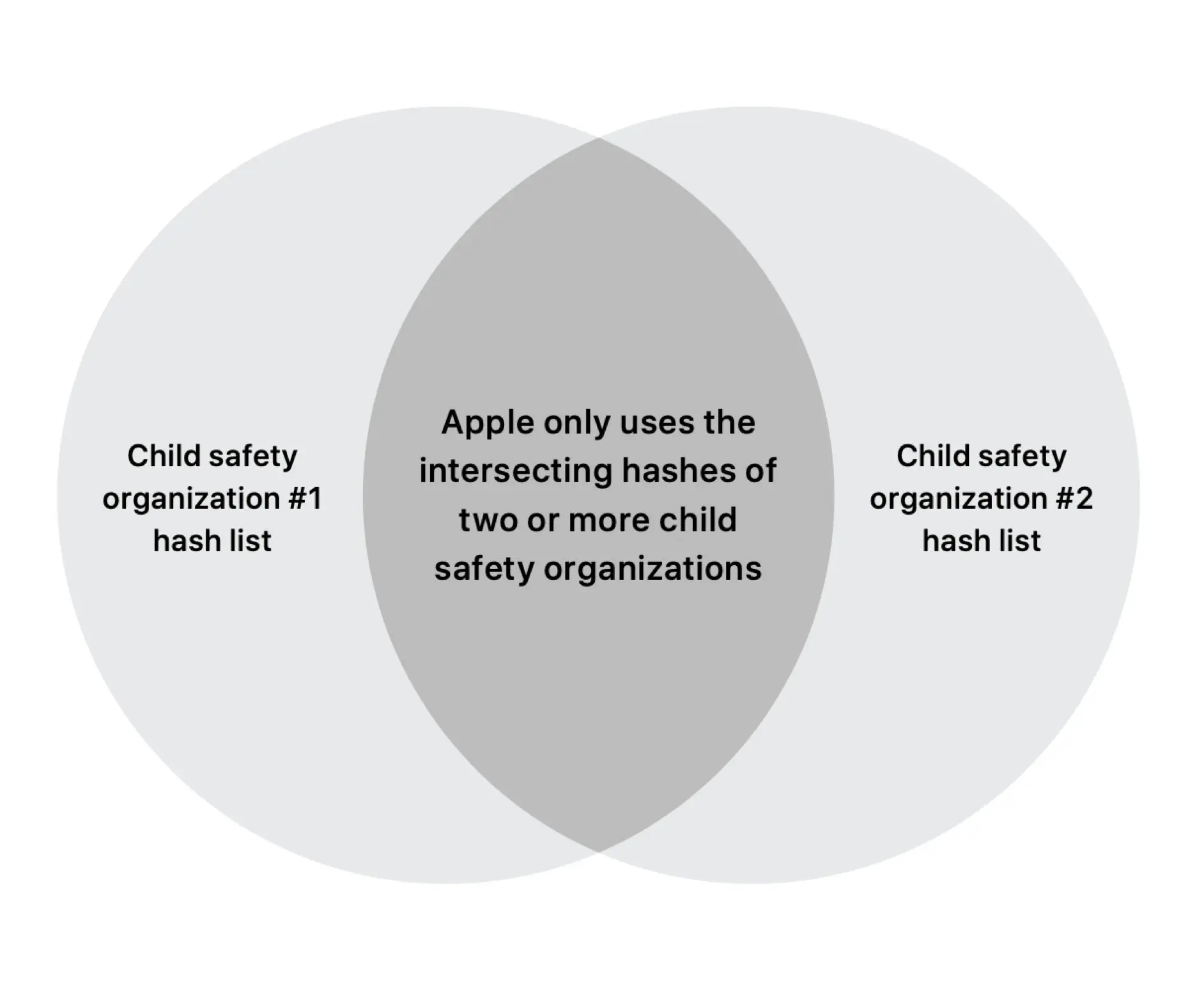

Việc này nhằm tăng tính khách quan của việc đối chiếu và đề cao quyền riêng tư của bạn. Apple nói khi phân tích ảnh trong máy người dùng để xác định ảnh có chứa nội dung lạm dụng trẻ em, hay CSAM, họ sẽ so sánh mã hash của ảnh đó với mã hash của ít nhất hai tổ chức bảo vệ trẻ thuộc hai quốc gia khác nhau.

Theo dòng sự kiện

Đọc theo thứ tự để nắm bắt câu chuyện về CSAM của Apple. Bài nào cũng hay, đọc nhanh hết 5 phút là biết rõ tình hình câu chuyện.

- Cách Apple dùng Machine Learning để bảo vệ trẻ em không bị lạm dụng online

- Apple mở rộng chương trình chống lạm dụng hình ảnh trẻ em cho bên thứ 3

- Apple phát hành bảng hỏi đáp về CSAM

- Thuật toán nhận diện CSAM của Apple bị đánh lừa, nhưng chỉ một phần

Đối chiếu khách quan và đề cao quyền riêng tư

Trước đây Apple chỉ nhắc đến việc dùng mã hash của một tổ chức National Center for Missing & Exploited Children (NCMEC) của Mỹ. Lý do vì họ chưa đạt được thỏa thuận với những tổ chức khác. Chứ thật ra họ sẽ so sánh ảnh (dưới dạng mã hash) với bộ hash của nhiều tổ chức khác. Tại sao?

Tại họ không muốn một quốc gia nào, kể cả Mỹ, âm thầm tuồn mã hash không phải CSAM vào cơ sở dữ liệu của tổ chức bảo vệ trẻ nhằm mục đích kiểm duyệt thông tin của người dùng. Khi một ảnh được đánh dấu là CSAM thì nó đã phải match với ít nhất hai bộ cơ sở dữ liệu CSAM của hai tổ chức khác nhau thuộc hai quốc gia khác nhau.

Điều này không những giúp tăng độ chính xác của việc nhận diện ảnh, hạn chế bị lừa mà còn giúp người dùng có thể yên tâm hơn. Không phải lo ngại việc một bức ảnh không phải CSAM mà lại bị khóa account iCloud vì một ý đồ nào khác.

Sự kiên định của Apple

Apple Senior Vice President mảng Software Engineering, ông Craig Federighi, chia sẻ rằng ổng biết tuần vừa rồi mọi người khá rối ren với vụ ‘quét ảnh’ của Apple, thậm chí lên án. Nhưng Apple vẫn đang hoàn thiện phương án và sẽ tuân theo đúng kế hoạch ban đầu.

Mã hash CSAM dùng để đối chiếu sẽ được đặt trong các phiên bản iOS và iPadOS của toàn cầu. Nhưng bước đầu sẽ chỉ xác minh CSAM với những tài khoản iCloud tại Mỹ. Apple sẽ cung cấp danh sách đầy đủ mã hash này cho các bên audit để họ đối chiếu với dữ liệu của các tổ chức bảo vệ trẻ. Cũng là một cách để chứng minh Apple không làm gì xằng bậy. Đồng thời từ chối các yêu cầu quét thêm những nội dung khác không phải CSAM từ chính phủ các nước. Tránh để bị lợi dụng cho mục đích giám sát người dân.

Một hệ thống có nhiều cấp audit độc lập

Trong buổi phỏng vấn với Wall Street Journal, ông Craig Federighi nói:

“Phần mềm (iOS, iPadOS) và cơ sở dữ liệu (CSAM) mà chúng tôi ship sang Trung Quốc so với cái ship ở Mỹ và châu Âu là như nhau. Nếu có ai đó đến gặp Apple yêu cầu quét dữ liệu mà không phải CSAM, Apple sẽ nói không. Nhưng nhiêu đó bạn chưa đủ tin. Bạn không muốn chỉ dựa trên lời nói đó của Apple. Bạn muốn chắc rằng kể cả khi chúng tôi nói OK đi chăng nữa thì cũng sẽ không thoát tội được“.

Ông Craig nói thêm rằng hệ thống nhận diện CSAM của Apple sẽ có nhiều cấp audit. Tờ Wall Street Journal cũng cho biết thêm là sẽ có một bên audit độc lập có thể xác nhận những tấm ảnh này. Nói cách khác, Apple sẽ không thể tự tung tự tác trong toàn bộ quá trình được. Họ muốn đảm bảo rằng bạn không cần phải đặt niềm tin vào bất kỳ một tổ chức đơn lẻ nào, hay một quốc gia riêng biệt nào.